Apple có thể đi sau OpenAI hay Google trong cuộc chạy đua AI, nhưng tốc độ họ nghiên cứu và công bố những sản phẩm mới, dự kiến sử dụng làm nền tảng cho những sản phẩm AI ứng dụng trong thiết bị công nghệ họ bán ra thị trường thì thực sự chóng mặt.

Trước khi OpenELM được công bố, Apple đã lần lượt hé lộ rất nhiều những mô hình AI và giải pháp xử lý dữ liệu hoặc tạo sinh dữ liệu bằng AI. Tốc độ họ công bố nghiên cứu khoa học và mô hình mã nguồn mở đúng là khiến chúng ta không thể bắt kịp:

Mới nhất, như tiêu đề, là OpenELM, mô hình ngôn ngữ được dùng làm nền tảng vận hành những tính năng chatbot hay trợ lý ảo, chạy local, tức là xử lý ngay trên những con chip như A17 Pro hay M3 của iPhone và MacBook, thông qua cả CPU, GPU lẫn Neural Engine để tạo sinh nội dung phục vụ người dùng.

Trước khi OpenELM được công bố, Apple đã lần lượt hé lộ rất nhiều những mô hình AI và giải pháp xử lý dữ liệu hoặc tạo sinh dữ liệu bằng AI. Tốc độ họ công bố nghiên cứu khoa học và mô hình mã nguồn mở đúng là khiến chúng ta không thể bắt kịp:

Apple âm thầm ra mắt mô hình AI chỉnh ảnh, đặt tên là MGIE, mạnh như Photoshop

Hôm qua mình ngồi đọc Reddit, trên mấy hội nhóm về chủ đề tạo hình bằng AI, có người phát hiện ra thông tin là 5 ngày trước trên GitHub, các nhà phát triển của Apple đã âm thầm cho ra mắt một mô hình chỉnh sửa hình ảnh dựa trên lệnh văn bản và mô…

tinhte.vn

Apple sắp cải tiến Siri bằng AI "ReALM": giúp Siri thông minh và phản hồi nhanh hơn

Các nhà nghiên cứu trí thông minh nhân tạo (AI) của Apple vừa hé lộ một công nghệ mới hứa hẹn sẽ giúp Siri thông minh và nhanh nhạy hơn. Công nghệ này có tên gọi là ReALM, viết tắt của cụm "Reference Resolution As Language Modelin" nôm na là xác…

tinhte.vn

Apple MM1: Mô hình AI nhận diện hình ảnh và văn bản, khá giống Circle to Search nhưng thông minh hơn

Trước khi công bố MM1, Apple cũng đã giới thiệu một mô hình AI được các kỹ sư của tập đoàn hợp tác với các nhà nghiên cứu đại học California phát triển, gọi là MGIE.

Nếu như MGIE (MLLM-Guided Image Editing) là giải pháp kết hợp giữa mô hình ngôn…

tinhte.vn

Mới nhất, như tiêu đề, là OpenELM, mô hình ngôn ngữ được dùng làm nền tảng vận hành những tính năng chatbot hay trợ lý ảo, chạy local, tức là xử lý ngay trên những con chip như A17 Pro hay M3 của iPhone và MacBook, thông qua cả CPU, GPU lẫn Neural Engine để tạo sinh nội dung phục vụ người dùng.

Nếu như GPT-4 hay Gemini là mô hình ngôn ngữ lớn đa chế độ (multimodal large language model), thì OpenELM là “mô hình ngôn ngữ nhỏ”. Vì kích thước, OpenELM đủ nhỏ gọn để chạy ngay trên phần cứng chiếc điện thoại của anh em. Tuy nhiên ở thời điểm hiện tại, OpenELM mới chỉ là mô hình phục vụ nghiên cứu công nghệ, chứ chưa được áp dụng cho bất kỳ sản phẩm thương mại hay dịch vụ nào vận hành trong những chiếc máy của Apple.

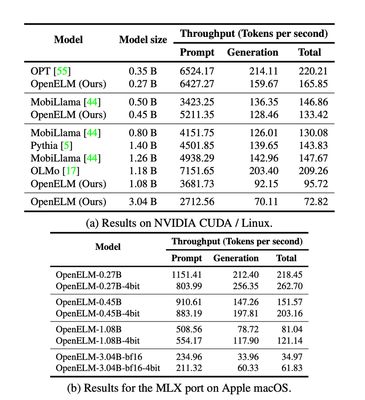

Điều đáng nói là hôm thứ 3, 23/4 vừa rồi, Microsoft cũng công bố một giải pháp tương tự, những mô hình Phi-3, với mục tiêu đủ sức thực hiện bước hiểu ngôn ngữ con người, đủ sức vận hành tạo sinh dữ liệu nhưng trong những mô hình với tham số đủ nhỏ để phần cứng thiết bị tiêu dùng có thể vận hành. Nếu như phiên bản Phi-3-mini của Microsoft có 3.8 tỷ tham số, thì OpenELM của Apple chỉ dao động từ 270 triệu đến 3 tỷ tham số, tùy thuộc vào 1 trong 8 phiên bản OpenELM được ứng dụng vận hành.

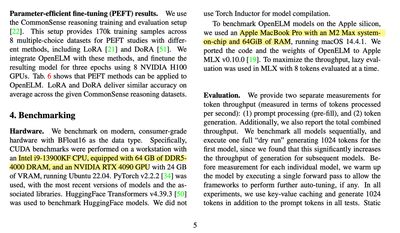

Context window, hay khung dữ liệu đầu vào để mô hình AI nhận diện ngữ cảnh của lệnh người dùng nhập và yêu cầu AI trả lời là 2048 token, tức là AI hiểu được tối đa ngần ấy từ hoặc chuỗi từ. Nó được các nhà khoa học tại Apple huấn luyện dựa trên gói dữ liệu RefinedWeb công khai trên mạng internet, giống như thư viện dữ liệu PILE nhưng được tuyển chọn và loại bỏ những dữ liệu lặp lại, và hai gói dữ liệu thuộc thư viện RedPajama và Dolma v1.6. Theo Apple, OpenELM được huấn luyện dựa trên 1.8 nghìn tỷ token dữ liệu dạng văn bản.

Chiến lược áp dụng để vận hành OpenELM, theo Apple, dựa trên từng lớp tính năng vận hành. Nhờ việc chia quá trình vận hành của mô hình AI thành nhiều lớp, các tham số của mô hình AI có thể được chia một cách hiệu quả hơn nhiều. Nói ngắn gọn, nhờ cơ chế này, tài nguyên phần cứng xử lý AI sẽ được tiết kiệm tối đa, cùng lúc cải thiện hiệu năng của chính bản thân mô hình AI, dù nó được huấn luyện dựa trên số lượng token dữ liệu thấp.

Vì có chữ “Open” trong cái tên, bản chất mô hình AI này là một mô hình mã nguồn mở được Apple phát triển. Bên cạnh weight AI vừa được công bố trên HuggingFace, Apple còn công khai cả thư viện dữ liệu CoreNet dùng để huấn luyện OpenELM, qua đó “củng cố và làm giàu nội dung cho cộng đồng nghiên cứu AI.” Nhưng cùng lúc, vì đây là những dữ liệu công khai tổng hợp từ mạng internet, nên các nhà nghiên cứu thuộc Apple cũng cảnh báo “có thể có khả năng những mô hình này tạo ra những thông tin không chính xác, có hại, thiên lệch hoặc không hợp lý để trả lời người dùng.”

Theo ArsTechnica