Xu hướng chung là, các tập đoàn công nghệ khổng lồ trong hơn hai năm vừa rồi đã rót hàng chục tỷ USD với lối tư duy là, trong ngành trí tuệ nhân tạo, càng nhiều thì càng mạnh và càng tốt. Nhưng đột phá của DeepSeek đang chứng minh một điều, nếu tìm được ra đúng cách, quy mô máy chủ đám mây nhỏ vẫn có thể tạo ra một AI không hề thua kém.

Những bàn luận sôi sục trên mọi nền tảng hay trong chính bản thân cộng đồng nghiên cứu AI toàn cầu đều xoay quanh một kỹ thuật gọi là “chắt lọc dữ liệu”. Ở đó, các kỹ sư của DeepSeek tìm ra cách để một hệ thống AI mới học kiến thức bàng cách hỏi chính một hệ thống AI có sẵn. Hệ thống và mô hình mới sẽ đặt ra hàng trăm nghìn, hàng triệu câu hỏi cho một AI có sẵn, rồi sau đó phân tích những câu trả lời.

CEO của Databricks, Ali Ghodsi giải thích quy trình “chắt lọc dữ liệu” theo cách dễ hiểu như thế này: “Nó giống như bạn có vài tiếng đồng hồ được ngồi phỏng vấn Albert Einstein, và sau cuộc phỏng vấn đó, bạn cũng là một người đầy kiến thức về vật lý như Einstein.”

Những cái tên được xếp vào top đầu những đơn vị nghiên cứu phát triển AI hiện giờ như OpenAI hay Anthropic về cơ bản thực hiện quy trình huấn luyện mô hình AI do họ phát triển từ con số 0, với lượng dữ liệu thô khổng lồ. Quy trình huấn luyện này thường tiêu tốn của một đơn vị khoảng thời gian vài tháng trời, với kinh phí vận hành data center từ vài chục triệu USD trở lên.

Những bàn luận sôi sục trên mọi nền tảng hay trong chính bản thân cộng đồng nghiên cứu AI toàn cầu đều xoay quanh một kỹ thuật gọi là “chắt lọc dữ liệu”. Ở đó, các kỹ sư của DeepSeek tìm ra cách để một hệ thống AI mới học kiến thức bàng cách hỏi chính một hệ thống AI có sẵn. Hệ thống và mô hình mới sẽ đặt ra hàng trăm nghìn, hàng triệu câu hỏi cho một AI có sẵn, rồi sau đó phân tích những câu trả lời.

CEO của Databricks, Ali Ghodsi giải thích quy trình “chắt lọc dữ liệu” theo cách dễ hiểu như thế này: “Nó giống như bạn có vài tiếng đồng hồ được ngồi phỏng vấn Albert Einstein, và sau cuộc phỏng vấn đó, bạn cũng là một người đầy kiến thức về vật lý như Einstein.”

Những cái tên được xếp vào top đầu những đơn vị nghiên cứu phát triển AI hiện giờ như OpenAI hay Anthropic về cơ bản thực hiện quy trình huấn luyện mô hình AI do họ phát triển từ con số 0, với lượng dữ liệu thô khổng lồ. Quy trình huấn luyện này thường tiêu tốn của một đơn vị khoảng thời gian vài tháng trời, với kinh phí vận hành data center từ vài chục triệu USD trở lên.

Nhưng với chắt lọc dữ liệu, mô hình AI sẽ được huấn luyện nhờ chính kết quả của quy trình huấn luyện AI truyền thống. V3 của DeepSeek được huấn luyện bằng dữ liệu kết quả huấn luyện những mô hình dùng để vận hành ChatGPT. Nhờ đó, các kỹ sư có thể tạo ra một mô hình với sức mạnh gần bằng mô hình trải qua quá trình huấn luyện lâu và tốn kém, chỉ mất vài tuần thậm chí vài ngày huấn luyện trên máy chủ, với chi phí thấp hơn rất nhiều. Xét riêng tới trường hợp của ChatGPT, quy định và điều khoản sử dụng dịch vụ hay API hoàn toàn cấm hành vi lợi dụng dữ liệu huấn luyện của OpenAI để phát triển một hệ thống cạnh tranh với họ.

Đấy chính là lý do hôm thứ 4 vừa rồi, OpenAI và Microsoft tuyên bố, có dấu hiệu cho thấy DeepSeek chắt lọc dữ liệu từ mô hình vận hành ChatGPT để xây dựng V3 hay R1.

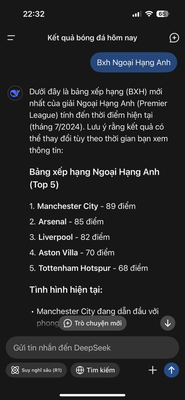

View attachment 8159153

Bản chất chắt lọc dữ liệu hữu ích để giảm thời gian huấn luyện một mô hình AI không mới. Nhưng giờ nó trở thành một chủ đề nóng trong mỗi cuộc đối thoại về AI đơn giản vì sự trỗi dậy của DeepSeek trong tuần qua. Những nghi hoặc và lo ngại về mô hình kinh doanh của các tập đoàn công nghệ khổng lồ, của các startup phương Tây, nơi thì đổ hàng chục tỷ USD, nơi thì… đi vay để đổ hàng tỷ USD vào quá trình phát triển mô hình AI thế hệ mới. Từ Google đến OpenAI, từ xAI tới Anthropic đều đang làm điều này.

Bằng chứng: Chỉ mới tuần trước thôi, tổng thống Donald Trump đã khoe về một dự án có tên là Stargate, một hệ thống các data center đặt trên khắp nước Mỹ. Ở đó, OpenAI, SoftBank cùng hàng loạt những tập đoàn lớn cam kết sẽ đổ 500 tỷ USD để xây dựng, giúp bảo vệ vị thế của nước Mỹ trong ngành trí tuệ nhân tạo.

Dự đoán được đưa ra, sẽ như thế nào nếu khoản đầu tư nửa nghìn tỷ Đô ấy không tạo ra được lợi thế cạnh tranh ở tầm vô địch, mà chính bản thân hệ thống này và quá trình huấn luyện mô hình AI theo kiểu truyền thống như mọi startup Mỹ đang làm hiện giờ chỉ đóng vai trò… bước đệm cho những đơn vị nhỏ, kinh phí thấp hay thậm chí đang phải chịu những quy định kiểm soát và cấm vận?

Nếu điều đó là thật, rất khó để hợp thức hoá một dự án như Stargate.

Quảng cáo

Thời điểm DeepSeek bùng nổ về danh tiếng và độ phủ, cũng đã bắt đầu xuất hiện tình trạng nơi những nhà đầu tư lẫn cả những giám đốc quản lý cấp cao ở Silicon Valley cân nhắc đánh giá lại mô hình kinh doanh của họ, để đặt ra những câu hỏi rằng quy trình để giữ họ dẫn đầu ngành như bây giờ có còn hợp lý về mặt tài chính?

Mike Volpi, một giám đốc lâu năm trong ngành công nghệ, giờ là một nhà đầu tư đang hợp tác với Hanabi Capital đặt ra câu hỏi: “Có lợi về khía cạnh kinh tế hay không, khi giữ vị thế là đơn vị sở hữu công nghệ tối tân bậc nhất, nhưng tốn kém gấp 8 lần so với cái tên đang bắt kịp rất nhanh về mặt công nghệ?”

Cả CEO Sam Altman của OpenAI lẫn Dario Amodei của Anthropic đều dành tặng những lời có cánh cho DeepSeek trên mạng xã hội. Altman mô tả mô hình mới nhất của DeepSeek là “một mô hình ấn tượng, đặc biệt ở khía cạnh hiệu năng mà nó đem lại so với chi phí” và rằng “chúng tôi háo hức tiếp tục triển khai roadmap nghiên cứu mô hình thế hệ mới.” CEO Amodei thì nói rằng mô hình V3 của DeepSeek “không phải một đột phá độc nhất vô nhị hay thứ gì đó thay đổi quy chuẩn kinh tế của việc vận hành những hệ thống AI cao cấp, mà là một cột mốc đã được dự đoán trước về việc giảm chi phí.”

Những giám đốc công nghệ thì dự đoán rằng dần dần sẽ có những ứng dụng AI chất lượng cao, vận hành dựa trên mô hình ngôn ngữ huấn luyện từ dữ liệu được “chưng cất”, “chắt lọc”. Các nàh nghiên cứu tại Hugging Face, nền tảng nghiên cứu phát triển AI đang cố gắng tạo ra một mô hình giống như V3 của DeepSeek. Nhà nghiên cứu cấp cao Lewis Tunstall cho biết: “Bước dễ nhất khi bắt chước quá trình là bước chưng cất dữ liệu.”

Dựa theo kết quả đánh giá của những bảng xếp hạng được viện dẫn nhiều nhất trong ngành, những mô hình của OpenAI và Google vẫn có chất lượng cao hơn V3 của DeepSeek. Đương nhiên những tập đoàn công nghệ khổng lồ vẫn sẽ giữ được vị thế dẫn đầu trong ngành, vì họ là những đơn vị bỏ cả sức người lẫn sức của để thực hiện nghiên cứu gốc.

Quảng cáo

Vấn đề nằm ở chỗ, nhiều người tiêu dùng và doanh nghiệp cảm thấy ổn khi sử dụng một công nghệ và mô hình “hơi kém hơn một chút” nhưng “rẻ hơn rất nhiều lần.”

Ở khía cạnh quản lý, David Sacks, cố vấn của tổng thống Donald Trump về vấn đề AI cho rằng, những doanh nghiệp Mỹ từ nay về sau sẽ tìm những cách để giới hạn khả năng sử dụng những mô hình do Mỹ tạo ra để chưng cất dữ liệu huấn luyện mô hình mới.

NovaSky, một đơn vị nghiên cứu thuộc đại học Berkeley, California hồi đầu tháng 1 vừa rồi đã công bố một công nghệ mà họ nói rằng có sức mạnh ngang ngửa với một mô hình OpenAI ra mắt gần đây. Để tạo ra mô hình mới, các nhà nghiên cứu thuộc trường đại học này chỉ tốn có 450 USD, tổng hợp và chắt lọc dữ liệu từ một mô hình mã nguồn mở do Alibaba của Trung Quốc phát triển.

Ngay lập tức mô hình được công bố dưới dạng mã nguồn mở này đã bắt đầu được ứng dụng để phát triển những công nghệ AI giá rẻ. Một ví dụ là Bespoke Labs, họ đã dùng mô hình mà NovaSky phát triển rồi bắt chính mô hình V3 của DeepSeek tổng hợp chắt lọc dữ liệu, tạo ra một mô hình mà họ tuyên bố có khả năng lập trình và giải quyết những bài toán ở chất lượng chấp nhận được.

Giáo sư Ion Stoica, chuyên ngành khoa học máy tính thuộc trường UC Berkeley nói: “Chắt lọc dữ liệu là một kỹ thuật cực kỳ hiệu quả để tạo ra thêm những khả năng mới cho một mô hình đã có sẵn.”

Trường hợp của DeepSeek chứng minh được một điều, kỹ thuật chắt lọc dữ liệu hoàn toàn có thể khiến cạnh tranh trong ngành công nghiệp AI, vốn đã rất gay gắt, giờ sẽ còn căng thẳng hơn. Hầu hết các tập đoàn hiện giờ đều chưa tìm được lợi nhuận từ việc vận hành những mô hình AI mà họ tốn tiền tỷ để phát triển, tất cả đều đốt tiền đổi lấy thị phần.

Giờ có thể đảm bảo một chuyện, cuộc chiến chi phí giá cho từng token AI nhận lệnh và tạo sinh sẽ còn diễn ra khốc liệt hơn trước rất nhiều. Hệ quả là một làn sóng chuyển dịch, khiến các tập đoàn càng lúc càng dè dặt trong việc đốt hàng tỷ USD để nghiên cứu ra những công nghệ AI mới và hiện đại nhất. Chi phí cho các lập trình viên và nhà phát triển ứng dụng tiếp cận với những API của OpenAI hay Anthropic trong năm qua đã giảm rất mạnh. Những mô hình mã nguồn mở như V3 sẽ còn khiến con số này giảm thêm, theo vài vị giám đốc trong ngành công nghệ.

Theo WSJ