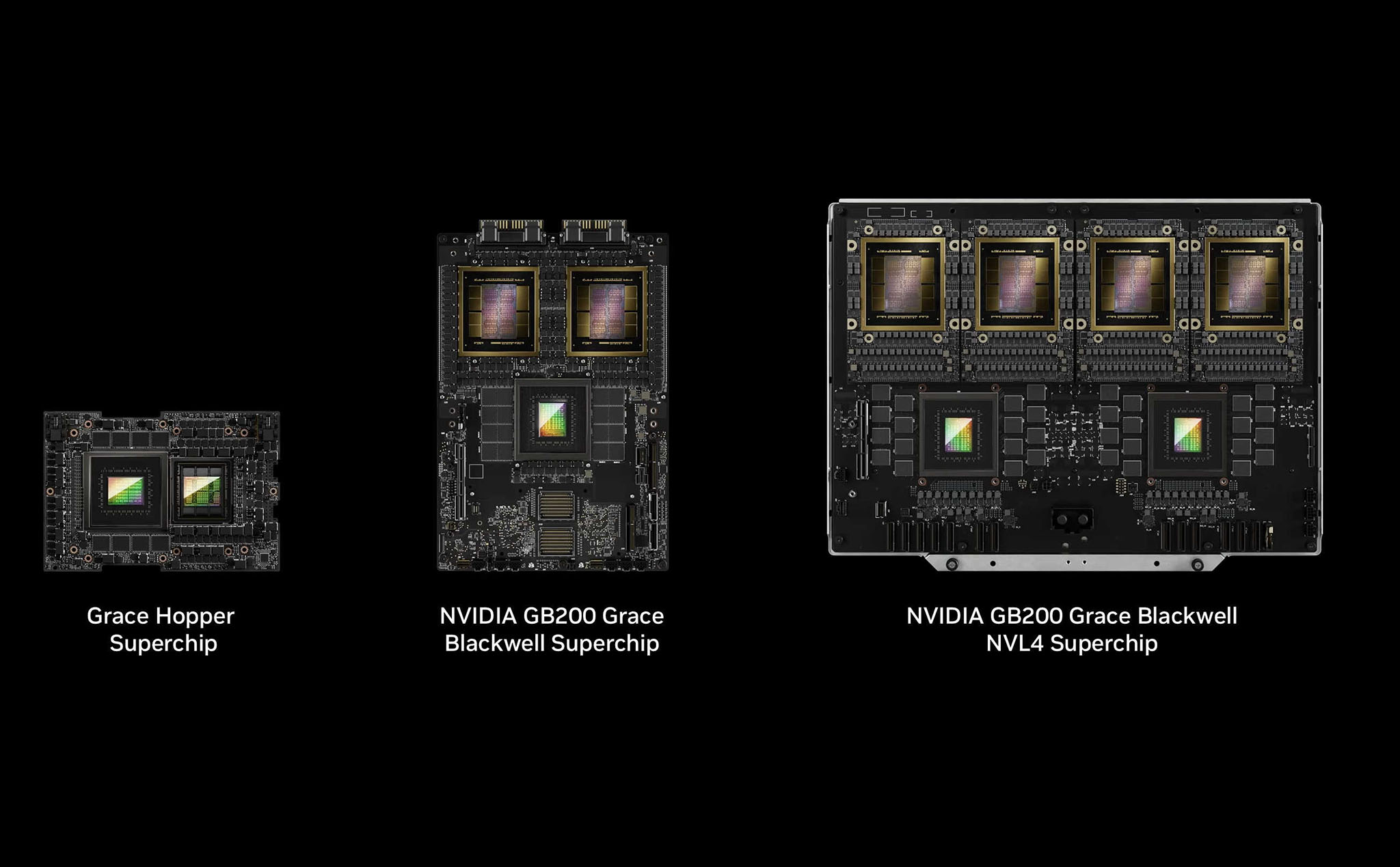

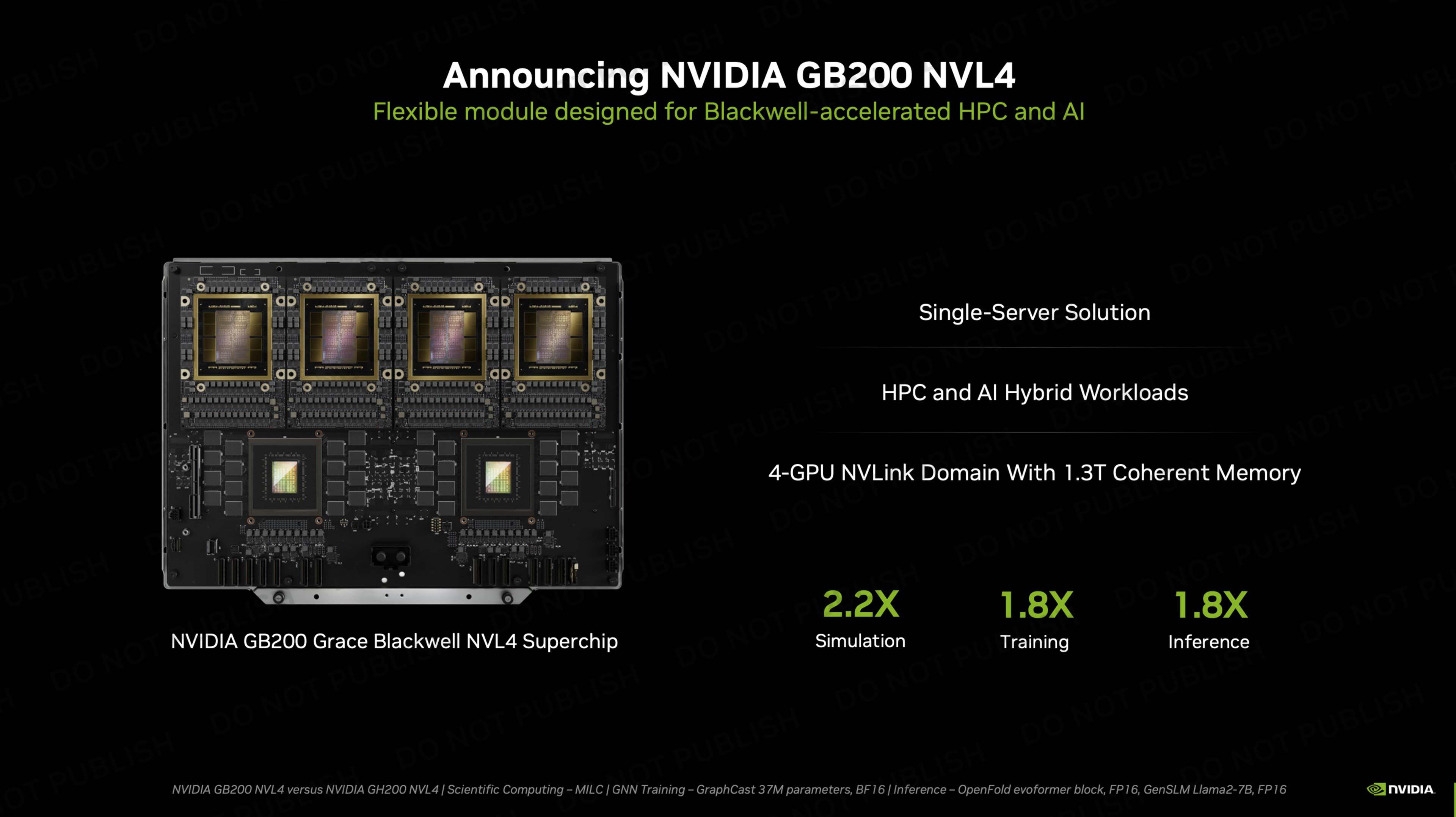

Tại sự kiện SC24 chuyên về siêu máy tính, NVIDIA vừa tung ra 2 giải pháp AI mới gồm GB200 NVL4 và H200 NVL. Trong đó, GB200 NVL4 trở thành tâm điểm vì đây là nền tảng AI mạnh mẽ nhất của công ty này và nó cũng... ngốn nhiều điện nhất! Với tổng cộng 4 GPU Blackwell và 2 CPU Grace, "siêu chip" này thực sự khiến chúng ta lo ngại vấn đề tản nhiệt.

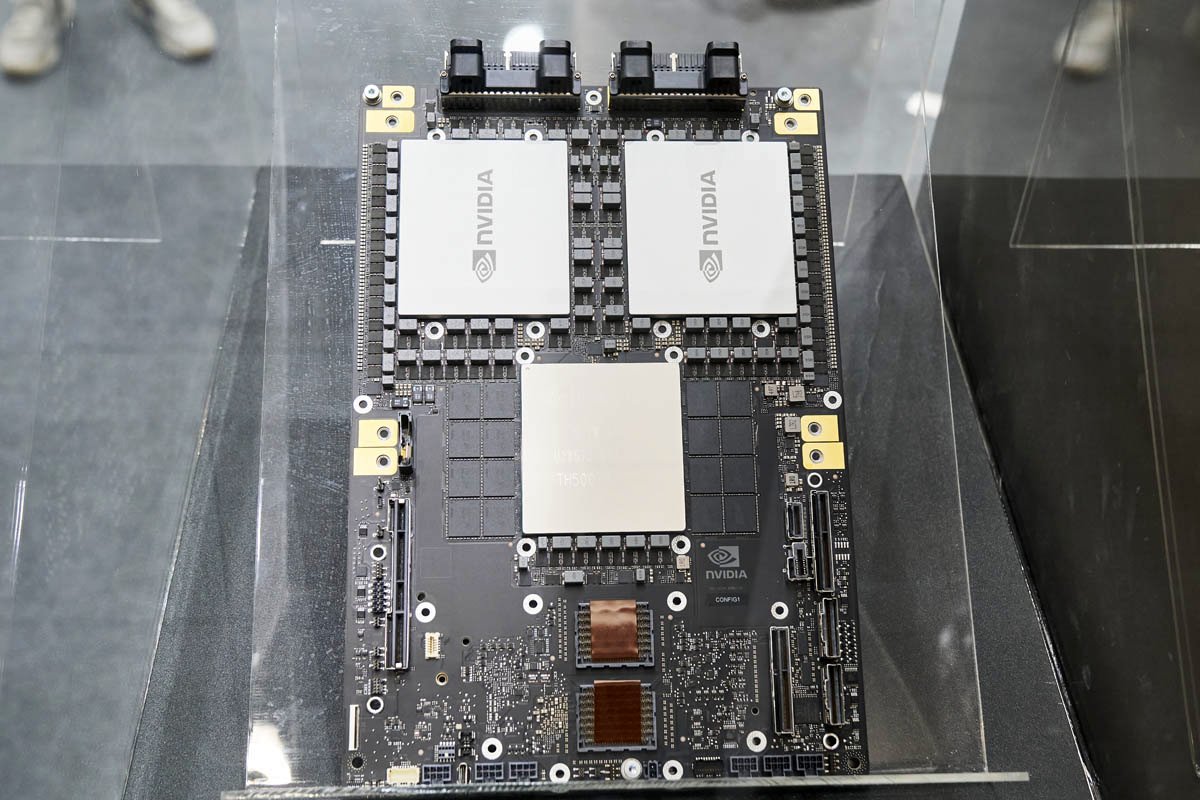

Chi tiết dễ nhận thấy nhất ở GB200 NVL4 là nó bự gấp đôi GB200 (tên gọi cả 2 model này khá dài dòng văn tự, gồm Grace Blackwell Superchip) với các con chip chính nhiều x2 phiên bản trước đó. Tuy vậy nếu xem xét kỹ, PCB GB200 NVL4 rộng rãi và thông thoáng hơn, các linh kiện được phân bố tự do và "ít bon chen" hơn. Thú vị hơn là "siêu chip" này nhét vừa một chiếc server và mình cho rằng tên gọi server phù hợp hơn là "siêu chip".

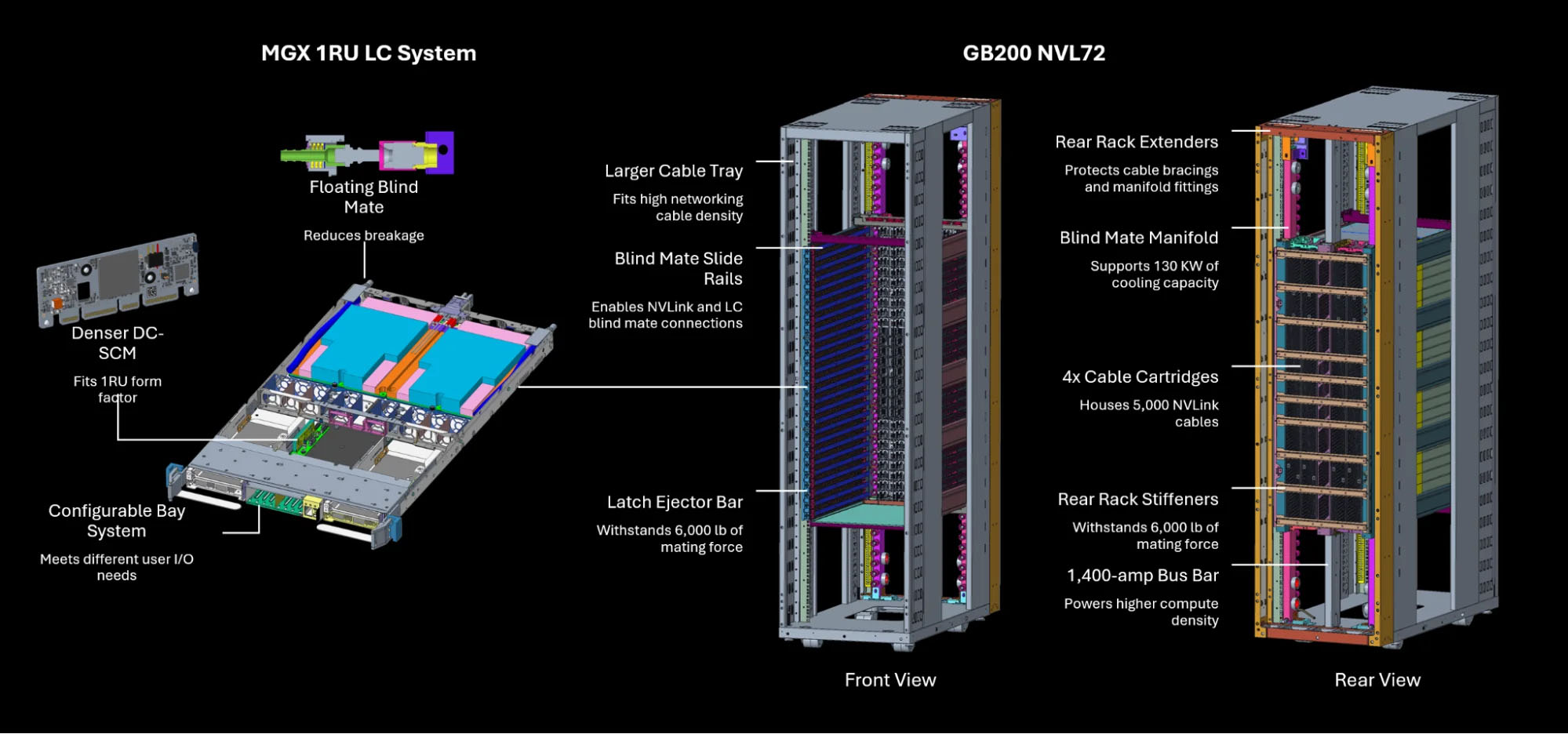

Một điểm nhấn khác ở GB200 NVL4 là nó không còn các chân cắm nằm ở trên góc PCB như phiên bản GB200 (dành cho server NVL72) ra mắt trước đó. Đây là điểm cộng về mặt thiết kế vì cùng để có 4 GPU trên 1 rack server, model cũ cần tới 2 PCB đặt song song nhau và cần thêm cáp nối chuyên biệt, khiến việc đi dây phức tạp hơn. Còn GB200 NVL4 thì mọi thứ trở nên đơn giản hơn.

"Siêu chip" hay server?

Chi tiết dễ nhận thấy nhất ở GB200 NVL4 là nó bự gấp đôi GB200 (tên gọi cả 2 model này khá dài dòng văn tự, gồm Grace Blackwell Superchip) với các con chip chính nhiều x2 phiên bản trước đó. Tuy vậy nếu xem xét kỹ, PCB GB200 NVL4 rộng rãi và thông thoáng hơn, các linh kiện được phân bố tự do và "ít bon chen" hơn. Thú vị hơn là "siêu chip" này nhét vừa một chiếc server và mình cho rằng tên gọi server phù hợp hơn là "siêu chip".

Một điểm nhấn khác ở GB200 NVL4 là nó không còn các chân cắm nằm ở trên góc PCB như phiên bản GB200 (dành cho server NVL72) ra mắt trước đó. Đây là điểm cộng về mặt thiết kế vì cùng để có 4 GPU trên 1 rack server, model cũ cần tới 2 PCB đặt song song nhau và cần thêm cáp nối chuyên biệt, khiến việc đi dây phức tạp hơn. Còn GB200 NVL4 thì mọi thứ trở nên đơn giản hơn.

GB200 NVL4 (trên) tại SC24 và GB200 NVL72 (dưới) tại Computex 2024

Song GB200 NVL4 vẫn có một vấn đề mà nhiều người lo ngại là mức tiêu thụ điện cũng như tản nhiệt. Có TDP tới 5400 W (gấp đôi bản cũ 2700 W), những công ty nào muốn khai thác sản phẩm này sẽ phải đầu tư nghiêm túc vào 2 vấn đề trên. Thực tế nếu chiếc server mới vẫn có chung 72 GPU và 36 CPU như bản cũ thì cơ bản không có gì thay đổi. Nhưng hiện tại NVL72 đều đang bị khách hàng của NVIDIA than phiền là quá nhiệt nên hoàn toàn có rủi ro lặp lại với GB200 NVL4.

GPU Blackwell đời mới nhất của Nvidia quá nhiệt, phải thiết kế lại máy chủ vận hành AI

Một bài viết mới đây của tờ tạp chí The Information đã dẫn nguồn vài đại diện của các đơn vị sản xuất máy chủ cũng như khách hàng của Nvidia. Những tuyên bố được The Information dẫn lại đều có chung một quan điểm, nói rằng Blackwell, chính xác...

tinhte.vn

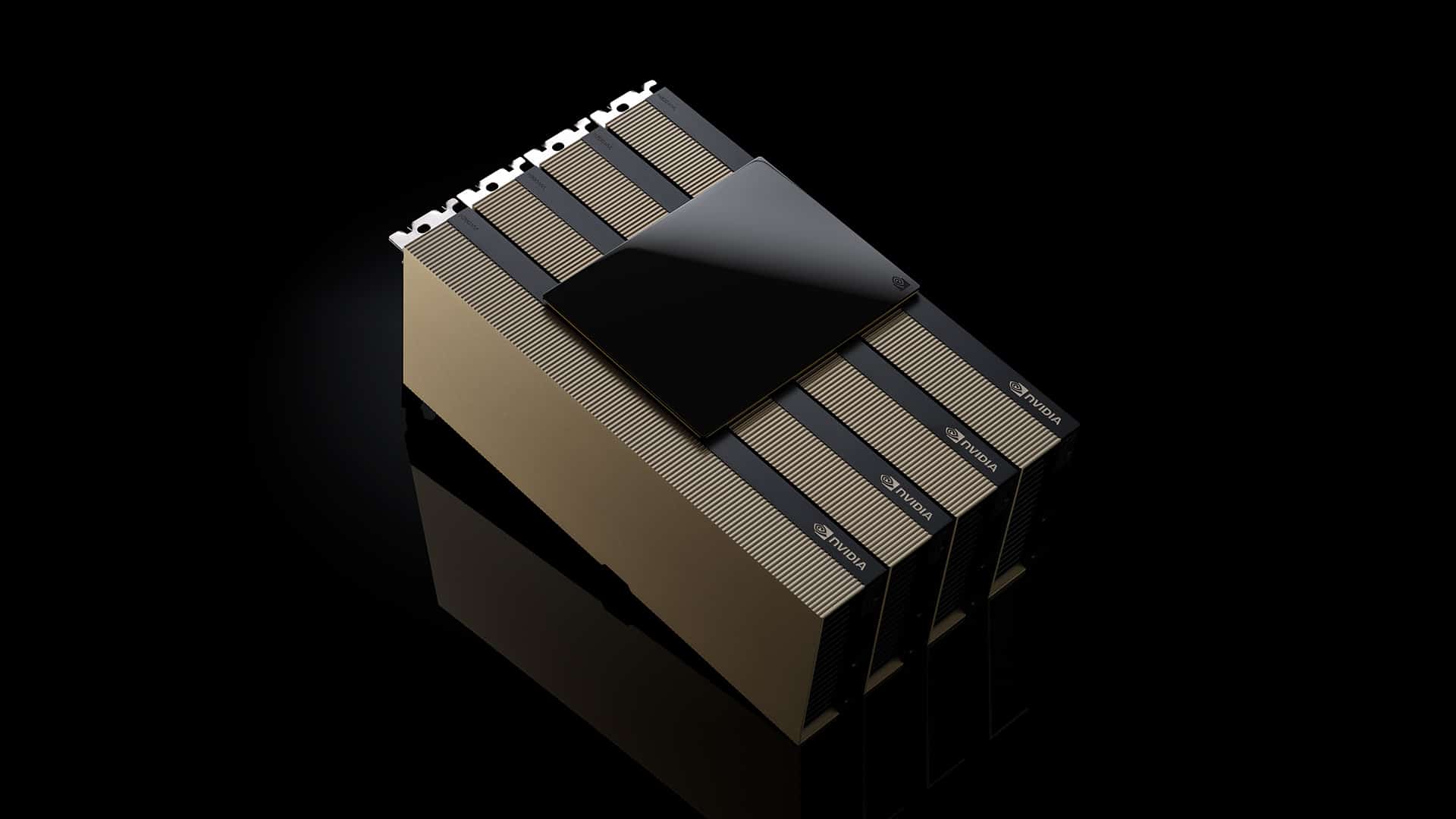

Về thông số sức mạnh, GB200 NVL4 được trang bị 768 GB chip nhớ HBM3E cho cả 4 GPU đi kèm với 960 GB chip nhớ LPDDR5X cho 2 CPU. "Siêu chip" này còn được trang bị thêm liên kết NVLink giúp liên kết toàn bộ các chip trên lại với nhau. NVIDIA cho biết GB200 NVL4 có năng lực mô phỏng gấp 2.2 lần, training và inference gấp 1,8 lần thế hệ trước là Grace Hopper Superchip. Sản phẩm này dự kiến sẽ được bán rộng rãi vào cuối năm nay thông qua các OEM như MSI, ASUS, GIGABYTE, Wistron, Pegatron, ASRock Rack, Lenovo, HPE...

Thiết kế 1 server NVL72 với 18 bay, mỗi bay chứa 2 "siêu chip" GB200 (cũ)

Card AI "giá rẻ"

Lại nói H200 NVL, tại sao NVIDIA lại ra một sản phẩm "đời cũ" trong hoàn cảnh này (H200 là Hopper)? Vì đây là giải pháp "mát mẻ" gồm 4 GPU H200 trong đó mỗi chiếc card PCIe có TDP không quá 600 W. Chi tiết này cũng có nghĩa H200 NVL sẽ có sức mạnh thấp hơn phiên bản SXM có TDP tới 700 W. Song đây là sự đánh đổi cần thiết vì không phải công ty hay datacenter nào cũng trang bị tản nhiệt chất lỏng.

Quảng cáo

Theo thăm dò của chính NVIDIA, 70% rack server doanh nghiệp có mức tiêu thụ điện dưới 20 kW và chỉ dùng tản nhiệt gió. Điều đó có nghĩa họ chỉ có thể sử dụng những con chip không đốt quá nhiều điện cũng như không toả quá nhiều nhiệt. Nếu NVIDIA muốn đánh vô tập khách hàng này thì buộc họ phải có giải pháp phù hợp. Và đó chính là H200 NVL.

Mặc dù H200 NVL sẽ yếu hơn H200 SXM nhưng nó sẽ nhanh hơn đáng kể thế hệ H100 NVL. Dung lượng bộ nhớ gấp 1.5 lần và băng thông nhớ gấp 1.2 lần phiên bản cũ. Năng lực inference gấp 1.7 lần cũng như năng lực HPC gấp 1.3 lần. Sản phẩm này dự kiến để các khách hàng cũ nâng cấp lên từ dòng chip Ampere (A100) ra mắt đã lâu. Trung bình H200 NVL nhanh gấp 2.5 lần các model A100.