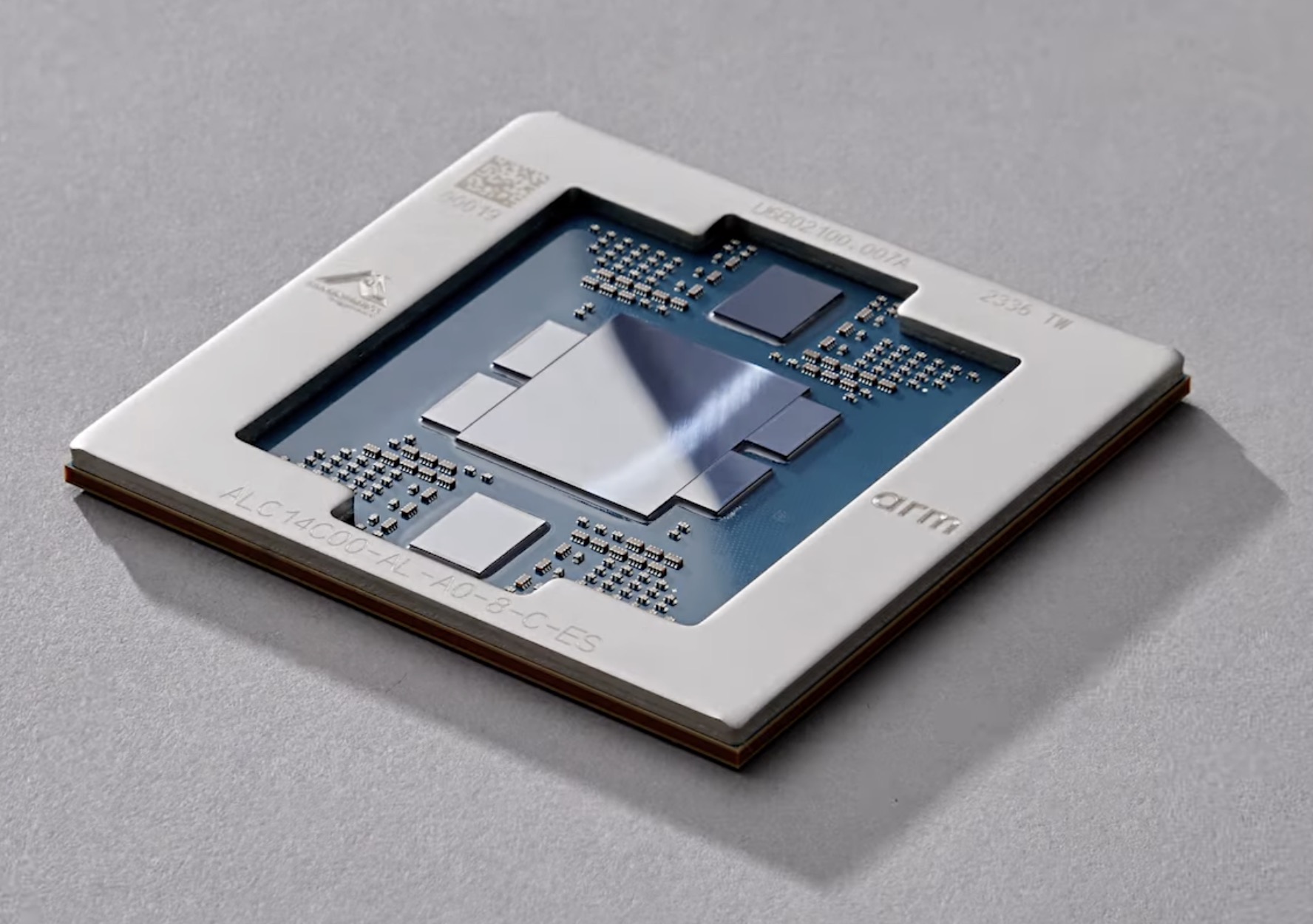

Amazon Web Services, dịch vụ điện toán đám mây của Amazon vừa tổ chức một hội thảo công nghệ mang tên re:Invent tại Las Vegas, Mỹ. Tại đây, họ đã công bố con chip kiến trúc ARM mang tên Trainium2, dựa trên kiến trúc Graviton4, dùng để vận hành huấn luyện những mô hình machine learning nói chung, và những LLM phục vụ vận hành những chatbot AI nói riêng.

Amazon cho biết, Trainium2 tạo ra hiệu năng cao gấp 4 lần, nhưng tiết kiệm điện năng gấp đôi so với thế hệ chip Trainium dùng huấn luyện thuật toán AI trước đó mà các kỹ sư AWS phát triển. Với Trainium2, những mô hình ngôn ngữ có thể được huấn luyện với số lượng tham số lên tới hàng nghìn tỷ.

Khi trang bị Trainium2 cho cụm data center phục vụ huấn luyện mô hình ngôn ngữ và mô hình machine learning, toàn bộ hệ thống có thể đạt hiệu năng xử lý số thực dấu phẩy động 65 exaflop, tức là ngang ngửa những hệ thống tầm cỡ siêu máy tính hiện giờ. Với sức mạnh như vậy, những mô hình ngôn ngữ với 300 tỷ tham số sẽ được huấn luyện chỉ trong vài tuần chứ không phải vài tháng.

Đó là con chip để huấn luyện AI. Còn AWS Graviton4 sẽ là chip xử lý dùng để trang bị và vận hành những tác vụ khác nhau trên Elastic Compute Cloud (EC2) Ultraclusters. Graviton4, theo Amazon, có hiệu năng cao hơn 30%, số nhân xử lý nhiều hơn 50%, và băng thông bộ nhớ cao hơn 75% so với thế hệ chip cũ, Graviton3.

Có vẻ như tập đoàn công nghệ khổng lồ nào cũng đang phát triển chip AI. Và dưới đây là những động thái của các tập đoàn lớn ấy trong khoảng nửa năm trở lại đây:

Amazon cho biết, Trainium2 tạo ra hiệu năng cao gấp 4 lần, nhưng tiết kiệm điện năng gấp đôi so với thế hệ chip Trainium dùng huấn luyện thuật toán AI trước đó mà các kỹ sư AWS phát triển. Với Trainium2, những mô hình ngôn ngữ có thể được huấn luyện với số lượng tham số lên tới hàng nghìn tỷ.

Khi trang bị Trainium2 cho cụm data center phục vụ huấn luyện mô hình ngôn ngữ và mô hình machine learning, toàn bộ hệ thống có thể đạt hiệu năng xử lý số thực dấu phẩy động 65 exaflop, tức là ngang ngửa những hệ thống tầm cỡ siêu máy tính hiện giờ. Với sức mạnh như vậy, những mô hình ngôn ngữ với 300 tỷ tham số sẽ được huấn luyện chỉ trong vài tuần chứ không phải vài tháng.

Đó là con chip để huấn luyện AI. Còn AWS Graviton4 sẽ là chip xử lý dùng để trang bị và vận hành những tác vụ khác nhau trên Elastic Compute Cloud (EC2) Ultraclusters. Graviton4, theo Amazon, có hiệu năng cao hơn 30%, số nhân xử lý nhiều hơn 50%, và băng thông bộ nhớ cao hơn 75% so với thế hệ chip cũ, Graviton3.

Có vẻ như tập đoàn công nghệ khổng lồ nào cũng đang phát triển chip AI. Và dưới đây là những động thái của các tập đoàn lớn ấy trong khoảng nửa năm trở lại đây:

Microsoft Maia/Cobalt 100: Chip AI tự phát triển, dùng vận hành Copilot và Bing Chat

Rõ ràng không có gì sánh được bằng những chip xử lý được thiết kế chuyên biệt cho từng tác vụ. Microsoft cũng hiểu điều đó. Vài năm qua đã có tin đồn nói rằng họ đang trong quá trình phát triển chip silicon phục vụ riêng nhu cầu xử lý thuật toán AI.

tinhte.vn

Intel khoe benchmark chip AI Gaudi2: Mạnh hơn Nvidia A100 khi nghiên cứu mô hình ngôn ngữ

Intel và startup nghiên cứu chip Habana Labs của họ vừa công bố kết quả benchmark MLPerf của con chip nghiên cứu machine learning Gaudi2. Với những con số được công bố, và khi Instinct MI300X của AMD chưa chính thức ra mắt…

tinhte.vn

NVIDIA chính thức giới thiệu GPU Hopper H200: GPU xử lý AI mạnh nhất thế giới

Tại sự kiện SC23 (Supercomputing 2023) mới diễn ra vào sáng nay, NVIDIA chính thức công bố GPU dựa trên kiến trúc Hopper mới là H200, chính là GPU chuyên về xử lý AI mạnh nhất mà loài người từng tạo ra.

tinhte.vn

AMD Instinct MI300X 192GB: Câu trả lời của AMD trước chip xử lý AI của Nvidia

Bên cạnh những con chip xử lý máy chủ EPYC, trong đó có cả những phiên bản trang bị 3D V-cache, tại sự kiện công bố sản phẩm doanh nghiệp của AMD, GPU flagship phục vụ xử lý HPC, data center nói chung và AI nói riêng…

tinhte.vn

Chán cảnh thiếu chip AI, OpenAI tính tự phát triển chip riêng vận hành ChatGPT

Reuters đưa tin, OpenAI đang nghiên cứu khả năng tự phát triển chip xử lý và vận hành thuật toán AI của họ. Dẫn nguồn giấu tên, Reuters cho biết đây là hệ quả của tình trạng khan hiếm chip và hệ thống GPU vận hành machine learning đang diễn ra trên…

tinhte.vn

Theo Techs65 exafloppot