Trong quá trình hoạt động, để có thể định hình thế giới, robot cần phải đưa ra các giả định hợp lý về môi trường xung quanh, và những gì có thể xảy ra trong một chuỗi các sự kiện. Một trong những cách mà con người tìm hiểu các yếu tố này được cho là thông qua âm thanh. Nhận biết được điều đó, các nhà nghiên cứu tại Viện Công nghệ Massachusetts (MIT - Mỹ) đã cố gắng áp dụng cách thức nhận biết thế giới của con người lên máy móc.

Cụ thể, các nhà khoa học tại Phòng thí nghiệm Khoa học Máy tính và Trí tuệ nhân tạo (CSAIL) thuộc MIT đã tạo ra một thuật toán hiệu quả trong việc dự đoán âm thanh: Khi chiếu một video không tiếng mô tả một đối tượng bị gõ vào, thuật toán có thể sản xuất một âm thanh phát ra từ tác động đó, đủ thực để đánh lừa người xem.

Trong tương lai, công nghệ này có thể được ứng dụng để tạo ra các hiệu ứng âm thanh cho phim ảnh và các chương trình truyền hình, cũng như giúp robot hiểu rõ hơn về đặc tính của đối tượng. "Khi bạn chạm ngón tay mình lên một ly rượu vang, âm thanh nó phát ra phản ánh có bao nhiêu chất lỏng trong đó", Andrew Owens - nghiên cứu sinh tại CSAIL, tác giả chính của nghiên cứu, cho biết.

"Một thuật toán mô phỏng các âm thanh như vậy có thể tiết lộ thông tin quan trọng về hình dạng đối tượng, loại chất liệu, cũng như các lực và chuyển động tương tác của chúng với thế giới". Để có thể làm được điều này, nhóm nghiên cứu đã ứng dụng công nghệ Deep learning, giúp máy tính sàng lọc lượng lớn dữ liệu nhằm tìm thấy các mẫu phù hợp.

Cách thức hoạt động

Cụ thể, các nhà khoa học tại Phòng thí nghiệm Khoa học Máy tính và Trí tuệ nhân tạo (CSAIL) thuộc MIT đã tạo ra một thuật toán hiệu quả trong việc dự đoán âm thanh: Khi chiếu một video không tiếng mô tả một đối tượng bị gõ vào, thuật toán có thể sản xuất một âm thanh phát ra từ tác động đó, đủ thực để đánh lừa người xem.

Trong tương lai, công nghệ này có thể được ứng dụng để tạo ra các hiệu ứng âm thanh cho phim ảnh và các chương trình truyền hình, cũng như giúp robot hiểu rõ hơn về đặc tính của đối tượng. "Khi bạn chạm ngón tay mình lên một ly rượu vang, âm thanh nó phát ra phản ánh có bao nhiêu chất lỏng trong đó", Andrew Owens - nghiên cứu sinh tại CSAIL, tác giả chính của nghiên cứu, cho biết.

"Một thuật toán mô phỏng các âm thanh như vậy có thể tiết lộ thông tin quan trọng về hình dạng đối tượng, loại chất liệu, cũng như các lực và chuyển động tương tác của chúng với thế giới". Để có thể làm được điều này, nhóm nghiên cứu đã ứng dụng công nghệ Deep learning, giúp máy tính sàng lọc lượng lớn dữ liệu nhằm tìm thấy các mẫu phù hợp.

Cách thức hoạt động

Bước đầu tiên để tạo ra một thuật toán có khả năng sản xuất âm thanh là cho nó ‘nghe’ âm thanh để học tập. Trong hàng tháng trời, các nhà nghiên cứu ghi được khoảng 1.000 video của khoảng 46.000 âm thanh, đại diện cho các đối tượng khác nhau bị đập, cạo và chọc vào với một cái dùi trống. Tiếp theo, nhóm nghiên cứu đưa những video này vào một thuật toán Deep learning để tách âm thanh đồng thời phân tích độ trầm/bổng, độ lớn và các đặc tính khác của chúng.

"Để đưa ra dự đoán về âm thanh của một video mới, thuật toán cần xem xét các đặc tính âm thanh của mỗi khung hình video, và so sánh chúng với những âm thanh tương tự có trong cơ sở dữ liệu", Owens nói. "Khi hệ thống nhận được các mẩu nhỏ âm thanh, nó khâu chúng lại với nhau để tạo ra một âm thanh hoàn chỉnh”. Kết quả là thuật toán có thể mô phỏng chính xác các âm thanh về những gì diễn ra trong video.

"Các phương pháp tiếp cận AI hiện tại chỉ tập trung vào một trong 5 giác quan, có nhà nghiên cứu sử dụng hình ảnh, có nhà nghiên cứu sử dụng âm thanh hay đại loại thế", Abhinav Gupta - trợ lý giáo sư robot tại Đại học Carnegie Mellon (Mỹ), người đã không tham gia vào nghiên cứu, nhận định. "Nghiên cứu này là một bước đi đúng trong việc bắt chước cách con người học tập, bằng cách tích hợp cả âm thanh lẫn hình ảnh".

Nhằm thúc đẩy sự ra đời của các thuật toán mới hoàn thiện hơn, 46.000 âm thanh thu được bởi các nhà khoa học MIT sẽ được cho phép sử dụng bởi các nhóm nghiên cứu khác, và dĩ nhiên là hoàn toàn miễn phí

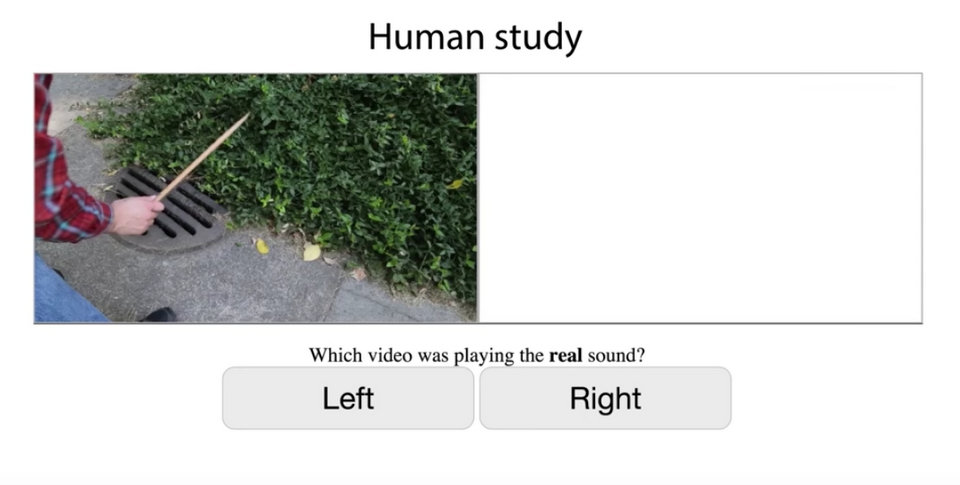

Đánh lừa con người

Để kiểm tra âm thanh mô phỏng bởi AI thực đến mức nào, nhóm nghiên cứu đã tiến hành một bài thử nghiệm trực tuyến, cho mọi người xem 2 đoạn video, một đoạn có âm thanh ghi lại từ thực tế, trong khi video còn lại với âm thanh tạo ra bởi thuật toán. Yêu cầu đối với các tình nguyện viên là hỏi họ xem đâu là video với âm thanh thật. Kết quả: số người chọn video có âm thanh giả gấp đôi số người chọn đúng.

Họ đặc biệt đánh bị đánh lừa bởi tiếp xúc của dùi với lá cây hoặc bùn đất, những âm thanh có phần ít rõ ràng hơn. Qua đó, nhóm nghiên cứu phát hiện âm thanh của vật liệu tiết lộ không ít khía cạnh quan trọng về tính chất vật lý của chúng.

Quảng cáo

Tiến về phía trước

Mặc dù đã cho thấy các kết quả khả quan, các nhà khoa học cho biết họ vẫn còn nhiều việc để làm nhằm cải thiện hệ thống. Chẳng hạn, nếu dùi trống di chuyển thất thường, thuật toán nhiều khả năng có thể bỏ lỡ hoặc ghi nhận sai các chuyển động. Ngoài ra, phạm vi hoạt động của hệ thống hiện vẫn khá hạn chế, và chỉ tỏ ra hữu ích đối với những âm thanh gây ra bởi các tương tác vật lý đang được miêu tả trong đoạn video.

"Từ tiếng gió thổi cho đến tiếng ù ù phát ra từ máy tính xách tay, ở bất kỳ thời điểm nào cũng có rất nhiều âm thanh xung quanh, những âm thanh không liên quan đến những gì chúng ta đang thực sự nhìn vào", Owens nói. "Thật thú vị khi chúng ta có thể tạo ra cách mô phỏng âm thanh có ít mối liên kết với hình ảnh”.

Nhóm nghiên cứu tin rằng những nâng cấp trong tương lai đối với công nghệ này, có thể cải thiện khả năng của robot trong việc tương tác với môi trường xung quanh. "Một con robot có thể nhìn vào vỉa hè và nhận biết được xi măng cứng và cỏ thì mềm mại, do đó, nó biết điều gì sẽ xảy ra nếu bước lên chúng", Owens nói. "Có thể dự đoán âm thanh là bước đi quan trọng đầu tiên, hướng tới việc có thể đoán những kết quả của sự tương tác vật lý với thế giới".

Tham khảo: MIT, Ảnh minh họa: Newsweek