Dùng cụm từ “Camera AI” để phân biệt máy ảnh hoạt động bằng thuật toán phần mềm với quá trình hình thành bức ảnh hoàn toàn bằng quang học vật lý. Chúng ta vẫn nghe “nhiếp ảnh là vẽ bằng ánh sáng” trong một cái “buồng tối”, nguồn sáng (tự nhiên hoặc nhân tạo) đi qua nhóm/lớp thấu kính được tráng phủ hoá chất phức tạp, cửa trập mở ra, ánh sáng xuyên vào, hội tụ trên một mặt phẳng vật liệu nhạy sáng. Tấm vật liệu nhạy sáng ấy là tấm phim (analog) hoặc tấm cảm biến hình ảnh (image sensor). Tấm phim được xử lý bằng hoá chất trong buồng tối để có được âm bản và rọi ra giấy ảnh hoặc dùng máy scaner film để có file ảnh số.

Còn với máy ảnh số thì tín hiệu ghi nhận được tại các điểm ảnh trên cảm biến ảnh tiếp tục qua quá trình xử lý thành file ảnh lưu vào thẻ nhớ. Chúng ta vẫn gọi đó là quá trình của thiết bị ghi hình kỹ thuật số, máy ảnh số. Thực hư thế nào?

Gần đây, ở đoạn phần mềm xử lý này, các nhà sản xuất camera hoặc gia công phần mềm, tăng cường thêm nhiều bước xử lý phức tạp với tín hiệu ánh sáng thu nhận được, xào nấu rất rất nhiều, thậm chí xử lý từng pixel, chồng ghép nhiều pixel từ nhiều tấm khác nhau .v.v… để tái tạo ra một bức ảnh kết quả cuối cùng, họ gọi là nhiếp ảnh điện toán, thuật toán xử lý ảnh, AI camera…

Còn với máy ảnh số thì tín hiệu ghi nhận được tại các điểm ảnh trên cảm biến ảnh tiếp tục qua quá trình xử lý thành file ảnh lưu vào thẻ nhớ. Chúng ta vẫn gọi đó là quá trình của thiết bị ghi hình kỹ thuật số, máy ảnh số. Thực hư thế nào?

Gần đây, ở đoạn phần mềm xử lý này, các nhà sản xuất camera hoặc gia công phần mềm, tăng cường thêm nhiều bước xử lý phức tạp với tín hiệu ánh sáng thu nhận được, xào nấu rất rất nhiều, thậm chí xử lý từng pixel, chồng ghép nhiều pixel từ nhiều tấm khác nhau .v.v… để tái tạo ra một bức ảnh kết quả cuối cùng, họ gọi là nhiếp ảnh điện toán, thuật toán xử lý ảnh, AI camera…

- Nhiếp ảnh Điện toán là gì?

Về từ gọi là “computational photography” (nhiếp ảnh điện toán). Wikipedia nói computational photography is a digital image capture and processing techniques that use digital computation instead of optical processes. Quá trình xử lý số thay vì quá trình quang học để có một bức ảnh. Mình tạm dùng cụm từ “nhiếp ảnh điện toán” ở đây như nhiều người đã dùng để tản mạn tiếp.

Người tiên phong về nhiếp ảnh điện toán, cũng là người đứng sau nhiều cải tiến cho máy ảnh Pixel của Google, ông Marc Levoy - giáo sư của trường đại học Stanford, đưa ra một định nghĩa cơ bản: “Nhiếp ảnh điện toán có thể giúp nâng cao hoặc mở rộng khả năng của nhiếp ảnh kỹ thuật số - trong đó kết quả đầu ra là một bức ảnh bình thường - nhưng là một bức ảnh không thể chụp được bằng máy ảnh truyền thống”. Smartphone khởi đầu cho những thứ này.

Thật ra, Smartphone cũng không có lựa chọn nào khác, ngoài việc mang lại sức sống cho một loại hình nhiếp ảnh mới này - nhiếp ảnh điện toán. Chúng ta biết cụm camera gắn trên smartphone có cảm biến rất nhỏ, khả năng nhiễu cao, ống kính cũng rất nhỏ và độ mở không thể lớn vì giới hạn kích thước. Về phương diện quang học vật lý, đó là trở ngại bất khả kháng cho đến khi các nhà lập trình tìm ra cách dùng điểm mạnh của chúng để khắc phục điểm yếu: cửa trập điện tử nhanh, bộ vi xử lý mạnh và phần mềm thuật toán.

- Bước khởi đầu xử lý số

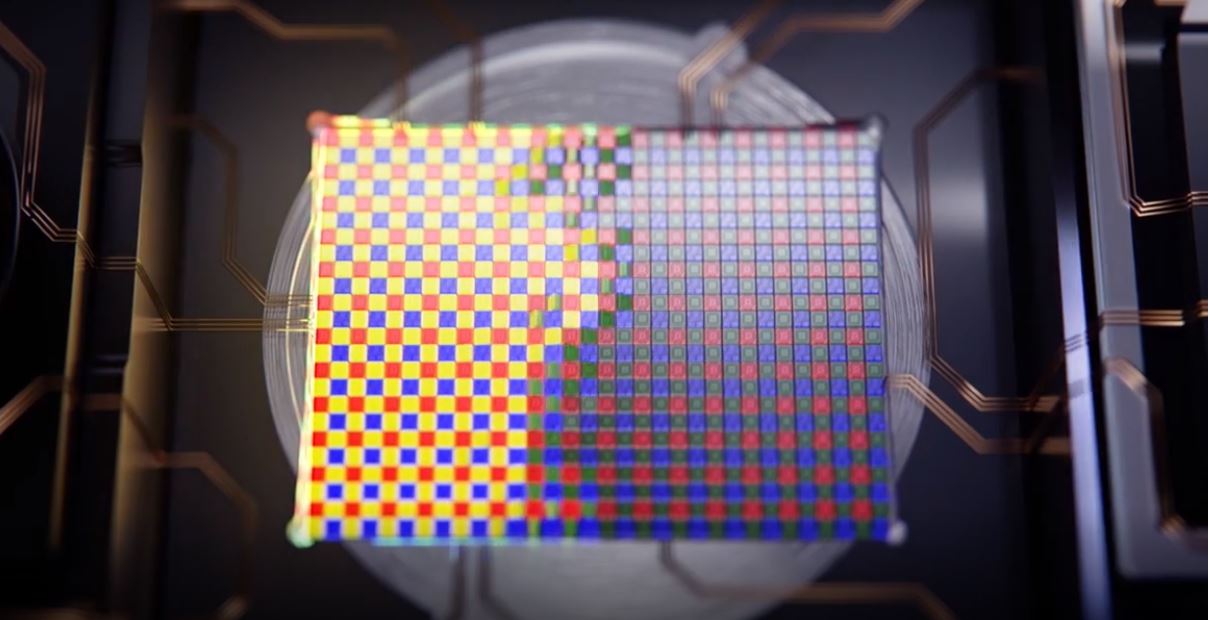

Nhớ lại việc Instagram ra mắt, mọi người ấn tượng với các bộ lọc màu (filter) khi chia sẻ hình ảnh lên nền tảng đó. Các filter màu có thể được phân thành ba loại chính:

- Thay đổi màu sắc (Hue, Saturation, Lightness, Contrast, Levels, v.v… ) với thanh chỉnh đơn giản.

- Tông màu (Tone Mapping) với thanh trượt hiệu chỉnh red với hue.

- Lớp phủ (Overlay) với các hoạ tiết, hạt, mờ góc… tạo hiệu ứng như ảnh chụp bằng phim.

Quảng cáo

- Cảm biến và quang học điện toán

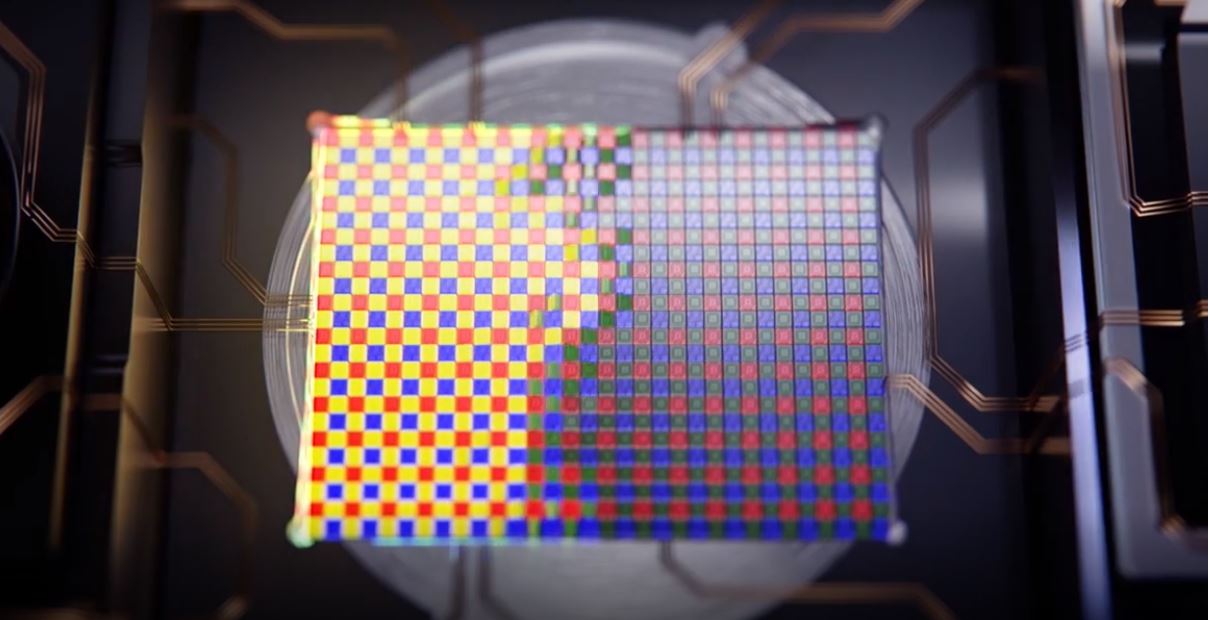

Về cảm biến, các nhà sản xuất có rất ít thay đổi về thiết kế từ ngày đầu tạo ra đến nay. Cải thiện chủ yếu là quy trình kỹ thuật, như giảm khoảng cách giữa các điểm ảnh, giảm nhiễu, tăng tốc độ đọc, thêm điểm ảnh cho hệ thống lấy nét theo pha. Cảm biến Pixel Shifting được coi là nỗ lực cải thiện cảm biến bằng thuật toán.

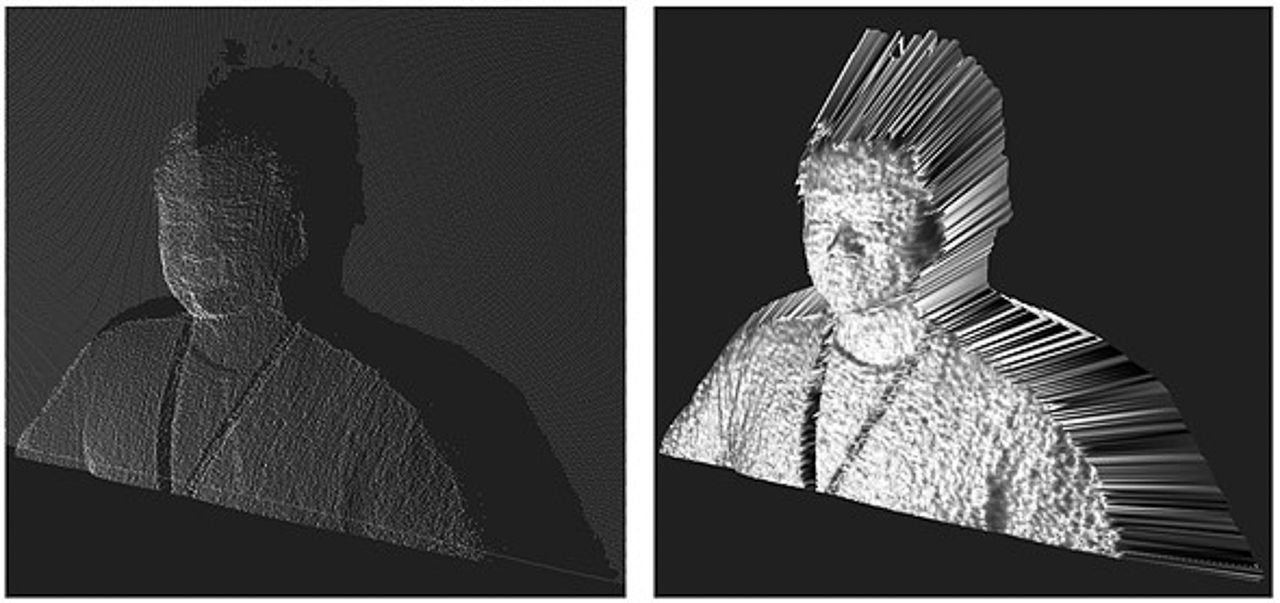

Google Pixel đã tính toán với một bản đồ độ sâu trường ảnh giả lập quang học (optical depht - field map) bằng cách phân tích 2 pixel cận kề, thay vì dùng một camera riêng để đo như các hãng khác. Chúng ta lùi về để thấy kỹ thuật này đã được Lytro sử dụng cho sản phẩm của họ từ 2012 dựa trên nghiên cứu của Đại học Stanford từ năm 2004.

Lytro sử dụng công nghệ chỉ khác máy ảnh thông thường là cảm biến được bao phủ rất nhiều cụm thấu kính, mỗi thấu kính phủ nhiều pixel thật. Đặt tấm lưới thấu kính đó với khoảng cách phù hợp với cảm biến, rồi lựa chọn thu nhận pixel từ mỗi cụm riêng và xây dựng hình ảnh từ chúng.

Điều hay ho thú vị bắt đầu từ đó. Nếu bạn nhặt một pixel từ mỗi cụm và trộn lại thành bức ảnh, giống như nó được chụp bằng máy ảnh với một pixel được dịch chuyển trong không gian. Nếu mỗi cụm là 10x10 pixel thì ta có 100 ảnh từ các vị trí khác nhau trên khung cảm biến.

Quảng cáo

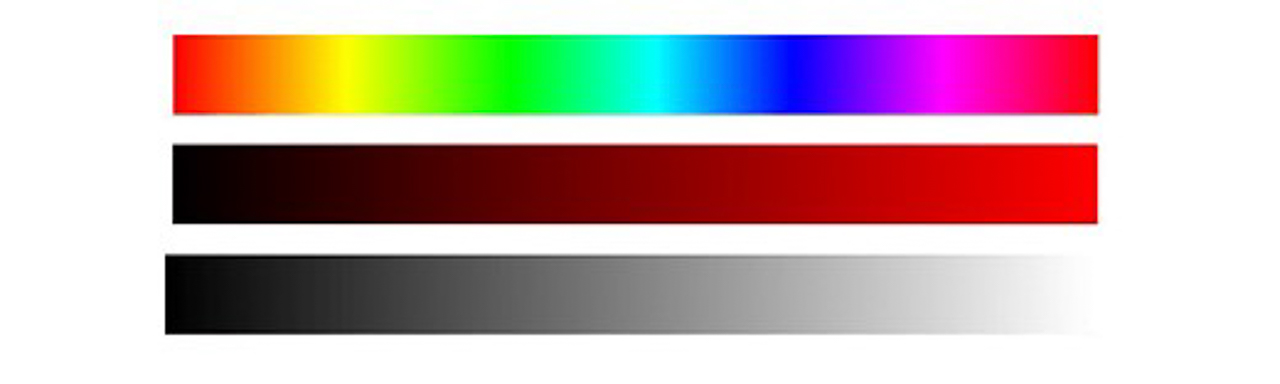

- Chuyện lấy nét lại của Lytro (refocusing) và đột phá của Google Pixel 2

Tính năng mà mọi người bàn nhiều về Lytro là khả năng lấy nét lại sau khi chụp. Họ sử dụng các pixel có sẵn, chọn lựa chúng từ ảnh RAW và ráp lại, cụm điểm ảnh càng xa tia gốc thì càng mất nét, nên chỉ cần chọn các pixel ở khoảng cách phù hợp với ảnh gốc theo cách gần hơn hoặc xa hơn. Để có bản đồ độ sâu (depth map), chỉ cần thu thập hai ảnh khác nhau rồi tính toán các đối tượng dịch chuyển giữa chúng.

Google quyết định mua lại công nghệ và khai tử Lytro. Nhưng Google sử dụng theo cách của họ với VR và camera Pixel. Bắt đầu với Pixel 2, chỉ với 2 pixel ở mỗi cụm, Google chỉ cần một camera, không cần gắn thêm một camera đo độ sâu như các hãng khác.

Depth map được xây dựng từ hai bức ảnh được dịch chuyển từ một pixel phụ. Đủ để tính toán bản đồ độ sâu và tách tiền cảnh khỏi hậu cảnh, làm mờ nó với một số hiệu ứng cho vùng ảnh mờ nhoè đó (cái mà người ta hay gọi là bokeh). Thuật toán làm mịn chỉ là cải thiện thêm bản đồ độ sâu. Google còn cho thấy điện thoại Pixel trong tương lai sẽ tiến xa hơn khi họ tăng số điểm ảnh trên mỗi cụm như nói bên trên.

- Tách lớp và xử lý nền ảnh

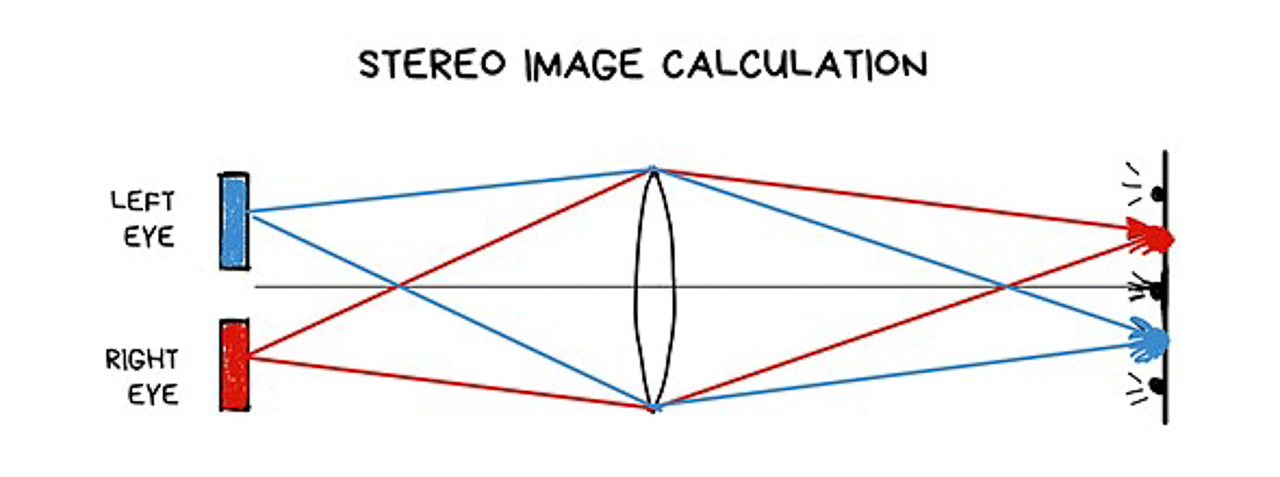

Bạn thử nhìn xuống mũi mình, sẽ không thấy vì não bộ kết hợp hình ảnh bằng việc tổng hợp hai ảnh từ hai mắt. Bây giờ bạn thử nhắm một mắt và nhìn xuống mũi, bạn sẽ thấy một góc tam giác rìa mũi.

Tương tự, việc tập hợp các ảnh được dịch chuyển từ các pixel từ các cụm khác nhau, có thể thấy đối tượng từ nhiều điểm, ước tính được khoảng cách gần đúng đến đối tượng, cho phép tính toán tách tiền cảnh khỏi hậu cảnh dễ dàng. Nếu đối tượng là chi tiết nhỏ, có thể xoá nó khỏi ảnh. Sao chép nó ra. Bằng cách này, có thể bỏ cây giữa ảnh, vật thể, hoặc loại bỏ hoa rơi xuống.

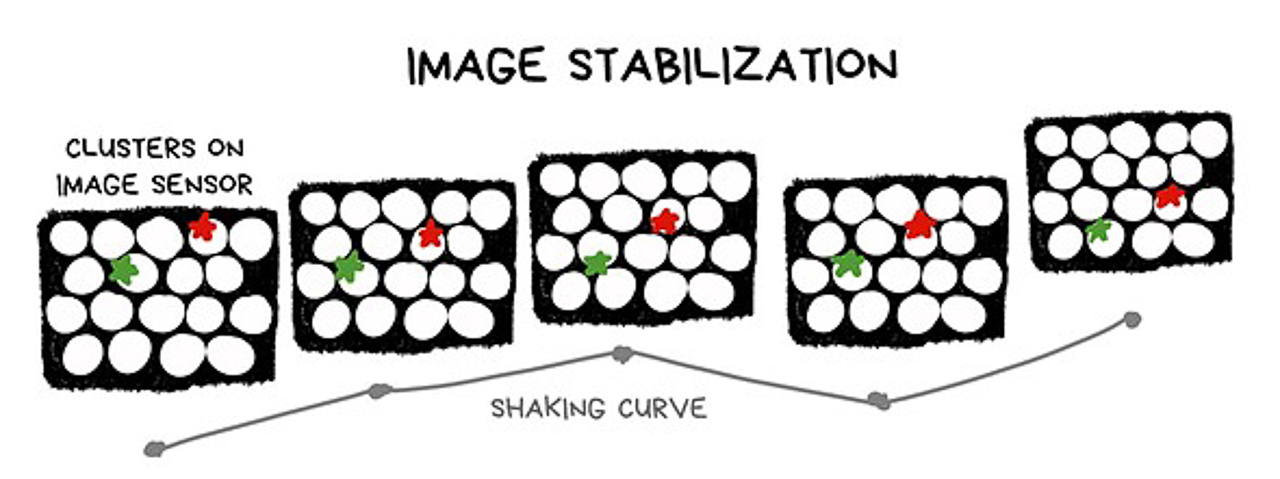

- Ổn định “quang học” mà không có quang học

Từ một ảnh RAW, bạn có thể tạo ra một trăm bức ảnh theo cách dịch chuyển pixel trên các vùng cảm biến. Tương tự, chúng ta có một thấu kính có thể dịch chuyển điểm chụp một cách tự do, bù lại độ rung của ảnh.

Về lý thuyết, là ổn định quang học, chẳng phải tính toán gì, chỉ chọn pixel đúng vị trí. Cảm biến và ống kính càng lớn thì khung chuyển động càng lớn. Càng nhiều tính năng thì càng nhiều lỗ thủng từ các mạch điện và giải nhiệt phát sinh. Và, hệ thống ổn định hình ảnh kỹ thuật số nào cũng hoạt động theo cách tương tự.

- Đèn flash

Từ lâu rồi, trên điện thoại thông minh, sử dụng đèn flash LED kép (dual led) - là sự kết hợp led màu vàng cam và xanh lam phối hợp, độ sáng được điều chỉnh theo nhiệt độ màu từ ảnh chụp. iPhone gọi là True Tone được điều khiển bằng cảm biến nhỏ đo ánh sáng xung quanh và xử lý bằng một đoạn thuật toán phức tạp.

Nhưng vấn đề của flash điện thoại là thường đánh sáng trắng tiền cảnh. Thế là iPhone hoá giải bằng slow sync flash, camera tăng tốc độ cửa trập trong bối cảnh tối; Google Pixel và các điện thoại Android khác sử dụng cảm biến độ sâu để trộn hai ảnh có và không có flash lại với nhau, rất nhanh.

Có lẽ chẳng bao lâu nữa, nhu cầu con người sẽ là muốn kiểm soát luôn ánh sáng sau khi đã hoàn thành việc chụp; lúc đó có thể thay bầu trời nhiều mây thành nắng, ánh sáng trên khuôn mặt được thay đổi nhanh và dễ. Khi đó, đèn flash chỉ được dùng như chiếc đèn pin.

- ToF camera

ToF (time of flight) camera là máy ảnh như cái máy đo ánh sáng đến các đối tượng để tạo ra bản đồ độ sâu của cảnh vật. Độ chính xác khá cao. Các hãng ứng dụng nhiều nhất và hiệu quả là Samsung và Huawei, sử dụng chung để tạo bản đồ chiều sâu, giả lập bokeh, lấy nét tự động trong bối cảnh tối tốt hơn. Có được độ sâu trường ảnh chính xác, là dữ liệu rất hữu ích cho việc nghiên cứu nhiều hơn về thuật toán trong tương lai, nhất là ứng dụng hình ảnh 3D.

Còn tiếp...

Tham khảo: graphics.stanford.edu